- Independance (probabilites)

-

Indépendance (probabilités)

L'indépendance est une notion probabiliste qualifiant de manière intuitive des événements aléatoires n'ayant aucune influence l'un sur l'autre. Il s'agit d'une notion très importante en statistique et calcul de probabilités.

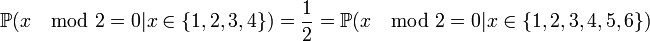

Par exemple, la valeur d'un premier lancer de dés n'a aucune influence sur la valeur du second lancer. De même, pour un lancer, le fait d'obtenir une valeur inférieure ou égale à quatre n'influe en rien sur la probabilité que le résultat soit pair ou impair[1] : les deux événements sont dits indépendants.

L'indépendance ou non de deux événements n'est pas toujours facile à établir.

Sommaire

Indépendance de deux évènements

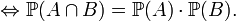

La définition mathématique de l'indépendance de deux évènements est la suivante :

Définition — A et B sont indépendants

La définition mathématique ci-dessus est assez peu parlante. Le lien entre le concept intuitif d'indépendance et la "formule produit" ci-dessus apparaît plus clairement si l'on introduit la notion de probabilité conditionnelle :

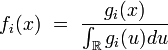

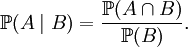

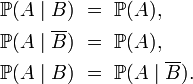

Définition — Si

la probabilité conditionnelle de A sachant B, notée

la probabilité conditionnelle de A sachant B, notée  est définie par la relation ci-dessous :

est définie par la relation ci-dessous :

En excluant les cas particuliers peu intéressants où B est impossible, et où B est certain, on peut alors reformuler la définition de l'indépendance de la manière suivante

Définition — Lorsque la probabilité de B n'est ni nulle, ni égale à 1, A et B sont indépendants si l'une des conditions suivantes, toutes équivalentes, est remplie :

Ainsi les évènements A et B sont dits indépendants si notre pronostic sur l'évènement A est le même :

- si on sait que l'évènement B s'est produit (pronostic

),

), - si on sait que l'évènement B ne s'est pas produit (pronostic

),

), - si on ne sait rien sur le statut de l'évènement B (pronostic

).

).

Autrement dit, A est dit indépendant de B si notre pronostic sur l'évènement A n'est affecté par aucune information concernant B, ni par l'absence d'information concernant B. On peut échanger les rôles de A et de B dans la définition utilisant les probabilités conditionnelles, à condition bien sûr d'exclure les cas particuliers peu intéressants où A est impossible, et où A est certain.

Bien que la définition utilisant les probabilités conditionnelles soit plus intuitive, elle a l'inconvénient d'être moins générale, et de ne pas faire jouer un rôle symétrique aux deux événements A et B.

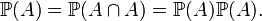

Notons par ailleurs qu'un évènement certain A est indépendant de tout évènement B quel qu'il soit. Un évènement impossible est également indépendant de tout autre évènement. En particulier, un événement A est indépendant de lui-même à la condition que A soit soit certain, soit impossible. En effet, si l'événement A est indépendant de lui-même, on peut écrire :

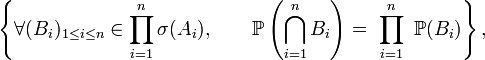

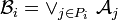

Indépendance de n évènements

La notion d'indépendance peut être étendue à n événements, via la notion d'indépendance des tribus, mais on va plutôt donner ici deux critères plus lisibles :

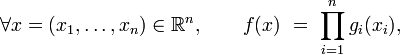

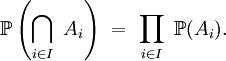

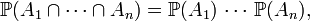

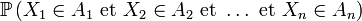

Critère 1 — n événements

sont dits indépendants si et seulement si, pour toute partie

sont dits indépendants si et seulement si, pour toute partie  on a

on a

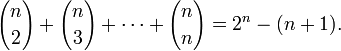

Le nombre total de conditions à vérifier est donc le nombre de parties

possédant au moins deux éléments, à savoir :

possédant au moins deux éléments, à savoir :

L'indépendance des n évènements

entraîne que

entraîne que

ce qui correspond au choix particulier

mais est une propriété beaucoup plus faible que l'indépendance. Dans le même esprit, comme on le constate dans l'exemple ci-dessous, n événements peuvent être indépendants deux à deux, ce qui correspond à vérifier la propriété pour toutes les parties

mais est une propriété beaucoup plus faible que l'indépendance. Dans le même esprit, comme on le constate dans l'exemple ci-dessous, n événements peuvent être indépendants deux à deux, ce qui correspond à vérifier la propriété pour toutes les parties  à 2 éléments, sans pour autant être indépendants :Exemple :

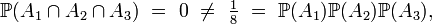

à 2 éléments, sans pour autant être indépendants :Exemple :On lance deux dés et on pose

- A1 : le résultat du lancer du dé n°1 est pair,

- A2 : le résultat du lancer du dé n°2 est pair,

- A3 : la somme des résultats des 2 lancers est impaire.

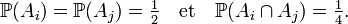

On a

alors que, pourtant, pour

choisis arbitrairement,

choisis arbitrairement,

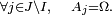

Critère 2 — n événements

sont dits indépendants si et seulement si, pour tout choix de

sont dits indépendants si et seulement si, pour tout choix de  on a

on a

où, par convention,

et

et

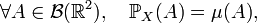

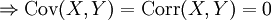

Indépendance des variables aléatoires

Définitions

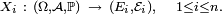

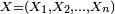

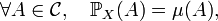

Il y a plusieurs définitions équivalentes de l'indépendance d'une famille finie de variables aléatoires. On peut en particulier définir l'indépendance d'une famille de tribus, et voir ensuite l'indépendance des évènements et l'indépendance des variables aléatoires comme des cas particuliers de l'indépendance des tribus. Cela permet de démontrer certains résultats généraux sur l'indépendance une seule fois, pour les tribus, puis d'en déduire la version "évènements" et la version "variables aléatoires" de ce résultat général immédiatement (un exemple est le lemme de regroupement). Cependant, il est peut-être préférable de donner d'abord deux définitions de l'indépendance des variables aléatoires qui soient opératoires pour les applications, et quelques critères commodes. Dans ce qui suit on considère une suite

de variables aléatoires définies sur le même espace de probabilité

de variables aléatoires définies sur le même espace de probabilité  , mais éventuellement à valeurs dans des espaces différents :

, mais éventuellement à valeurs dans des espaces différents :

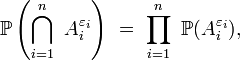

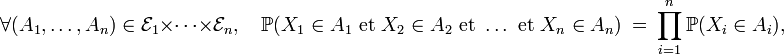

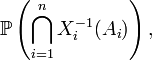

Définition —

est une suite de variables aléatoires indépendantes si l'une des deux conditions suivantes est remplie :

est une suite de variables aléatoires indépendantes si l'une des deux conditions suivantes est remplie :

- on a l'égalité

- pour n'importe quelle suite de fonctions

définies sur

définies sur  à valeurs dans

à valeurs dans  dès que les espérances ci-dessus ont un sens.

dès que les espérances ci-dessus ont un sens.

Les espérances ci-dessus ont un sens si les

sont mesurables, et si

sont mesurables, et si  est intégrable, ou si les

est intégrable, ou si les  sont positives ou nulles. Typiquement, dans les applications,

sont positives ou nulles. Typiquement, dans les applications,  Dans le cas de deux variables aléatoires réelles cela donne :

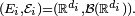

Dans le cas de deux variables aléatoires réelles cela donne :Définition — Deux variables aléatoires réelles X et Y sont indépendantes si l'une des deux conditions suivantes est remplie :

- on a

- pour tout couple de fonctions boréliennes

et

et  dès que les espérances ci-dessus ont un sens.

dès que les espérances ci-dessus ont un sens.

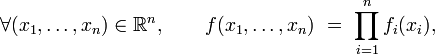

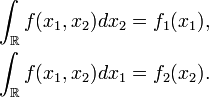

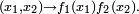

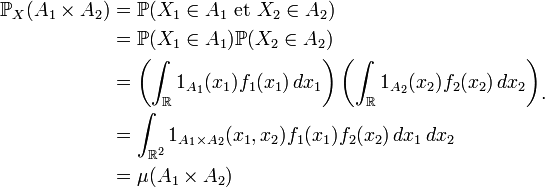

Cas des variables aléatoires à densité

Soit une suite

de variables aléatoires réelles définies sur le même espace de probabilité

de variables aléatoires réelles définies sur le même espace de probabilité

Théorème —

- Si

possède une densité de probabilité

possède une densité de probabilité  qui s'écrit sous forme "produit" :

qui s'écrit sous forme "produit" :

- où les fonctions

sont boréliennes et positives ou nulles, alors

sont boréliennes et positives ou nulles, alors  est une suite de variables indépendantes. De plus, la fonction

est une suite de variables indépendantes. De plus, la fonction  définie par

définie par

- est une densité de la composante

- Réciproquement, si

est une suite de variables aléatoires réelles indépendantes de densités de probabilité respectives

est une suite de variables aléatoires réelles indépendantes de densités de probabilité respectives  alors

alors  possède une densité de probabilité, et la fonction

possède une densité de probabilité, et la fonction  définie par

définie par

- est une densité de probabilité de

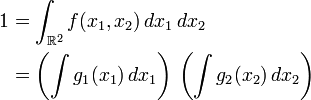

Démonstration dans le cas de deux variablesSens direct.

Comme la densité

est sous forme produit, on a

est sous forme produit, on a

et par suite

Par construction les fonctions

sont d'intégrale 1, donc

sont d'intégrale 1, donc

Ainsi les fonctions

sont les densités de probabilités marginales des deux composantes de

sont les densités de probabilités marginales des deux composantes de  Par suite, pour tout couple de fonctions

Par suite, pour tout couple de fonctions  et

et  tel que le premier terme ci-dessous ait un sens, on a

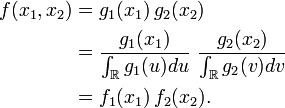

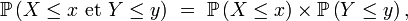

tel que le premier terme ci-dessous ait un sens, on a![\begin{align}

\operatorname{E}[\varphi(X_1)\psi(X_2)]

&= \int \int \varphi(x_1)\psi(x_2)f(x_1,x_2) \, dx_1 \, dx_2\\

&= \int \int \varphi(x_1)f_1(x_1)\psi(x_2)f_2(x_2) \, dx_1 \, dx_2\\

&= \int \varphi(x_1)f_1(x_1) \, dx_1 \int \psi(x_2)f_{2}(x_2) \, dx_2\\

&= \operatorname{E}[\varphi(X_1)] \operatorname{E}[\psi(X_2)]\end{align}](/pictures/frwiki/97/a8b338883e671d5d74de0cef24cab297.png)

ce qui entraine l'indépendance des variables

et

et

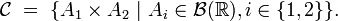

Sens réciproque. Il suffit de montrer que

où

est la loi de

est la loi de  et où

et où  est la mesure ayant pour densité

est la mesure ayant pour densité  Or

Or

où

est la classe des pavés boréliens :

est la classe des pavés boréliens :

En effet

On remarque alors que

est un π-système et que la tribu engendrée par

est un π-système et que la tribu engendrée par  est

est  donc, en vertu du lemme d'unicité des mesures de probabilités,

donc, en vertu du lemme d'unicité des mesures de probabilités,

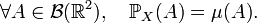

Autres critères d'indépendance

Par exemple,

Critères — Soit X et Y deux variables aléatoires réelles définies sur un espace probabilisé

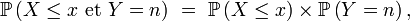

- Si, pour tout couple (x,y) de nombres réels,

- alors X et Y sont indépendantes.

- Si Y est à valeurs dans

et si, pour tout couple

et si, pour tout couple

- alors X et Y sont indépendantes.

- Bien sûr, si X et Y sont à valeurs dans

et si, pour tout couple

et si, pour tout couple

- alors X et Y sont indépendantes.

Par exemple, on peut utiliser le deuxième critère pour démontrer que dans la méthode de rejet, le nombre d'itérations est indépendant de l'objet aléatoire (souvent un nombre aléatoire) engendré au terme de ces itérations.

On peut généraliser ces critères d'indépendance à des familles finies quelconques de variables aléatoires réelles, dont certaines, éventuellement, sont des variables discrètes, à valeurs dans des parties finies ou dénombrables de

éventuellement différentes de

éventuellement différentes de  La démonstration de ces critères se trouve à la page "Lemme de classe monotone".

La démonstration de ces critères se trouve à la page "Lemme de classe monotone".Indépendance et corrélation

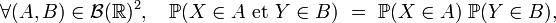

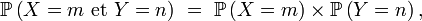

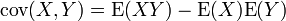

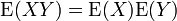

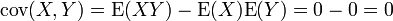

L'indépendance implique que la covariance, et donc la corrélation, entre les deux variables est nulle:

Théorème — X et Y sont indépendantes

Démonstration

DémonstrationCette propriété se déduit très facilement si l'on exprime la covariance comme:

. Comme on l'a vu, l'indépendance de X et Y entraîne que

. Comme on l'a vu, l'indépendance de X et Y entraîne que  , donc

, donc  .

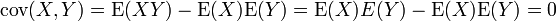

.La réciproque du théorème est fausse, comme le montre l'exemple suivant:

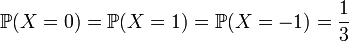

Exemple :Cet exemple est tiré de Ross (2004, p. 306)

- Soit X une variable aléatoire discrète telle que

.

.

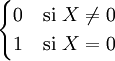

- Définissons Y en relation avec X :

- On calcule

![\operatorname{E}[XY]= \frac{1}{3}(0\cdot 1)+\frac{1}{3}(1\cdot 0)+\frac{1}{3}(-1\cdot 0)=0](/pictures/frwiki/100/dfc196782450e0bc07740f1aecf0e937.png) .

.

- On voit aussi que

![\operatorname{E}[X]= \frac{1}{3}(0)+\frac{1}{3}(1)+\frac{1}{3}(-1)=0+1-1=0](/pictures/frwiki/53/5277d6ef3dccbbd60320d9236b44e249.png) .

.

- donc:

.

.

- Pourtant les deux variables ne sont bien évidemment pas indépendantes!

La non-corrélation entre X et Y est une propriété plus faible que l'indépendance. En fait l'indépendance entre X et Y est équivalente à la non-corrélation de φ(X) et de ψ(Y) pour tout choix de φ et de ψ (tels que la covariance de φ(X) avec ψ(Y) soit définie ...).

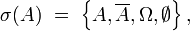

Indépendance des tribus

Définition — Dans un espace probabilisé

- une famille finie

de tribus incluses dans

de tribus incluses dans  est une famille de tribus indépendantes si et seulement si

est une famille de tribus indépendantes si et seulement si

- une famille quelconque

de tribus incluses dans

de tribus incluses dans  est une famille de tribus indépendantes si et seulement si toute sous famille finie de

est une famille de tribus indépendantes si et seulement si toute sous famille finie de  est une famille de tribus indépendantes (c'est-à dire, si et seulement si, pour toute partie finie I de J,

est une famille de tribus indépendantes (c'est-à dire, si et seulement si, pour toute partie finie I de J,  est une famille de tribus indépendantes).

est une famille de tribus indépendantes).

Lien avec l'indépendance des évènements

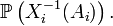

Définition — Une famille

d'évènements (i.e. d'éléments de

d'évènements (i.e. d'éléments de  ) est une famille d'évènements indépendants si et seulement si

) est une famille d'évènements indépendants si et seulement si  est une famille de tribus indépendantes.

est une famille de tribus indépendantes.Comme la tribu

engendrée par

engendrée par  est décrite par :

est décrite par :

la définition donnée dans cette section pour une famille quelconque d'évènements, une fois particularisée à une famille de

évènements, apparait comme plus forte que les deux critères donnés plus haut. En effet, pour un choix approprié des évènements

évènements, apparait comme plus forte que les deux critères donnés plus haut. En effet, pour un choix approprié des évènements  dans la définition

dans la définition

donnée dans cette section, on retrouve le critère 1 (choisir tantôt

tantôt

tantôt  dans

dans  ) et le critère 2 (choisir tantôt

) et le critère 2 (choisir tantôt  tantôt

tantôt  dans

dans  ). Pourtant les critères 1 et 2 sont effectivement équivalents à la définition via les tribus, donnée dans cette section, mais cela mérite démonstration.

). Pourtant les critères 1 et 2 sont effectivement équivalents à la définition via les tribus, donnée dans cette section, mais cela mérite démonstration.Lien avec l'indépendance des variables aléatoires

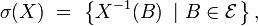

Définition — Une famille

de variables aléatoires définies sur

de variables aléatoires définies sur  est une famille de variables aléatoires indépendantes si et seulement si

est une famille de variables aléatoires indépendantes si et seulement si  est une famille de tribus indépendantes.

est une famille de tribus indépendantes.Comme la tribu

engendrée une variable aléatoire

engendrée une variable aléatoire  définie de

définie de  dans

dans  est définie par :

est définie par :

la définition donnée dans cette section pour une famille quelconque de variables aléatoires, une fois particularisée à une famille de

variables aléatoires, est clairement équivalente à la définition de la section Indépendance des variables aléatoires. En effet

variables aléatoires, est clairement équivalente à la définition de la section Indépendance des variables aléatoires. En effet

est un abus de notation pour

et

est un abus de notation pour

Propriétés élémentaires

Propriétés —

- Une sous-famille d'une famille de tribus indépendantes est une famille de tribus indépendantes : si la famille

est une famille de tribus indépendantes et si

est une famille de tribus indépendantes et si  alors

alors  est une famille de tribus indépendantes .

est une famille de tribus indépendantes . - Si, pour tout

la tribu

la tribu  est incluse dans la tribu

est incluse dans la tribu  et si la famille

et si la famille  est une famille de tribus indépendantes, alors la famille

est une famille de tribus indépendantes, alors la famille  est une famille de tribus indépendantes.

est une famille de tribus indépendantes.

Pour démontrer le premier point on applique la définition de l'indépendance à la famille

en spécialisant à une famille

en spécialisant à une famille  d'évènements telle que

d'évènements telle que  Le second point est immédiat : il suffit d'écrire la définition de l'indépendance de la famille

Le second point est immédiat : il suffit d'écrire la définition de l'indépendance de la famille

Lemme de regroupement

Lemme de regroupement — Dans un espace probabilisé

soit une famille quelconque

soit une famille quelconque  de tribus indépendantes incluses dans

de tribus indépendantes incluses dans  Soit une partition

Soit une partition  de

de  Notons

Notons

la tribu engendrée par

Alors la famille

est une famille de tribus indépendantes.Applications :

est une famille de tribus indépendantes.Applications :Dans le cas fini, on en déduit, par exemple, que si (X1 , X2 , X3 , X4 , X5 ) est une famille de variables indépendantes, et ƒ et g deux fonctions quelconques (mesurables), alors ƒ(X2 , X3 , X5 ) et g(X1 , X4 ) sont deux variables indépendantes, car {2, 3, 5} et {1, 4} forment une partition de {1, 2, 3, 4, 5}.

Indépendance et information

Une autre façon d'appréhender cette notion d'indépendance entre deux événements est de passer par l'information (au sens de la théorie de l'information) : deux événements sont indépendants si l'information fournie par le premier événement ne donne aucune information sur le deuxième événement.

Soit à tirer deux boules (rouge et blanche) d'une urne. Si on réalise l'expérience sans remettre la boule tirée dans l'urne, et que la première boule tirée est rouge, on peut déduire de cette information que la deuxième boule tirée sera blanche. Les deux événements ne sont donc pas indépendants.

Par contre, si on remet la première boule dans l'urne avant un deuxième tirage, l'information du premier événement (la boule est rouge) ne nous donne aucune information sur la couleur de la deuxième boule. Les deux événements sont donc indépendants.

Cette approche est notamment utilisée en analyse en composantes indépendantes.

Voir aussi

- Lemme de Borel-Cantelli

- Loi du 0-1

- Nombre univers

- Loi des grands nombres

- Théorème de la limite centrale

- Marche aléatoire

- Tribu (mathématiques)

- Analyse en composantes indépendantes

Notes

- ↑ En effet

Références

- T.-A. Banh, Calcul des probabilités, Ed. ULg, 1995.

- A. Hyvärinen, E. Oja, Independent Component Analysis, Neural Networks, 13(4-5):411-430, 2000.

- (en) Sheldon M Ross, Initiation Aux Probabilités, Presses polytechniques et universitaires romandes, Lausanne, p. 458

- (en) Olav Kallenberg, Foundations of Modern Probability, Springer, coll. « Probability and Its Applications », 1997 (réimpr. 2001), 638 p. (ISBN 0-387-95313-2)

- Portail des probabilités et des statistiques

Catégorie : Probabilités - si on sait que l'évènement B s'est produit (pronostic

Wikimedia Foundation. 2010.

![\mathbb{E}\left[\prod_{i=1}^n\ \varphi_i(X_i)\right]\ =\ \prod_{i=1}^n\mathbb{E}\left[\varphi_i(X_i)\right],](/pictures/frwiki/53/569363073b172b7350de06f174c09ef6.png)

![\operatorname{E}\left[g(X)\cdot h(Y)\right] = \operatorname{E}[g(X)]\cdot \operatorname{E}[h(Y)]](/pictures/frwiki/56/83508d40129516d62851e1166239d5aa.png)